Das Netzwerkdurchsetzungsgesetz1 (im Folgenden NetzDG) verpflichtet Soziale Netzwerke mit mehr als 2 Millionen registrierten Nutzern in Deutschland, „offensichtlich rechtswidrige“ Inhalte (z.B. ein Video oder Kommentar) nach Erhalt einer Rechtsbeschwerde innerhalb von 24 Stunden zu entfernen oder zu sperren. Ist die Rechtswidrigkeit nicht offensichtlich, hat der Anbieter bis zu sieben Tage Zeit, um über den Fall zu entscheiden. Nur in Ausnahmefällen darf es länger dauern, z.B. wenn die Inhalteersteller aufgefordert werden, eine Stellungnahme bezüglich ihres Inhalts abzugeben, oder wenn der Fall an eine Einrichtung der Regulierten Selbstregulierung zur Entscheidung weitergeleitet wird. Um in den Anwendungsbereich des NetzDG zu fallen, muss der Inhalt unter einen der 22 Straftatbestände des Strafgesetzbuches (StGB) fallen, auf die das NetzDG verweist.

Zudem prüfen wir Inhalte, die uns im Rahmen des NetzDG gemeldet werden, anhand unserer eigenen weltweiten YouTube-Community-Richtlinien2. Wenn der Inhalt gegen diese Richtlinien verstößt, entfernen wir ihn weltweit. Wenn der Inhalt nicht unter diese Richtlinien fällt, wir ihn aber gemäß einem der 22 Straftatbestände, auf die das NetzDG verweist (§1 Abs. 3 NetzDG), oder einem anderen lokalen Gesetz als rechtswidrig einstufen, sperren wir ihn lokal.

YouTube stellt in diesem Bericht Informationen über Entfernungen von Inhalten, zugehörige Richtlinien und Beschwerdeverfahren vor, die im Rahmen des NetzDG Anwendung finden.

1 https://www.gesetze-im-internet.de/netzdg/index.html

2 https://www.youtube.com/intl/de/yt/about/policies/#community-guidelines

Allgemeine Ausführungen zum Umgang mit angeblich rechtswidrigen Inhalten

Heute werden jede Minute über vierhundert Stunden Videomaterial auf YouTube hochgeladen, was die Plattform zu einer der größten existierenden Sammlungen menschlichen Schaffens macht, die jemals an einem Ort zusammengetragen wurde; eine Gemeinschaft, in der Menschen auf der ganzen Welt Ideen und Meinungen entwickeln und austauschen können. YouTube muss sicherstellen, dass sich die Nutzer an Regeln halten, die dem Schutz und der Erhaltung dieser Gemeinschaft dienen. Unsere Community-Richtlinien verbieten bestimmte Kategorien von Inhalten, einschließlich pornographischer Inhalte, Spam, Hassrede, Belästigung und Anstiftung zur Gewalt.

Wir halten uns an deutsche und andere lokale Gesetze. Wenn wir Entfernungsersuchen bezüglich angeblich rechtswidriger Inhalte erhalten, prüfen wir diese sorgfältig. Verstößt ein gemeldeter Inhalt gegen unsere Community-Richtlinien, so entfernen wir diesen weltweit. Verstößt er nicht gegen unsere Community-Richtlinien, aber gegen einen der Straftatbestände, auf die das NetzDG verweist, oder ein anderes lokales Gesetz, so wird dieser von uns als rechtswidrig eingestufte Inhalt lokal gesperrt. Dies ist derselbe Ansatz, den wir auch bei allen anderen rechtlichen Anfragen zur Entfernung von Inhalten verfolgen. Wie wir in diesem Bericht ausführlich darlegen, kann die Entscheidung, ob Inhalte nach lokalen Gesetzen rechtswidrig sind, eine äußerst komplexe rechtliche Analyse erfordern.

Die Bestrebungen von YouTube, eine engagierte globale Online-Gemeinschaft aufzubauen, können ohne die Bemühungen von bereichsübergreifenden Teams aus Spezialisten für unsere Richtlinien, Juristen, Ingenieuren, Produktmanagern, Datenanalysten, Prüfern für Inhalte, operativen Analysten, Spezialisten für bestimmte Bedrohungsszenarien und vielen anderen nicht gelingen. Darüber hinaus spielen die Hinweise und Anregungen der weltweiten Gemeinschaft von Nutzern, NGOs, Regierungen und Industriepartnern – einschließlich anderer Technologieunternehmen – eine wichtige Rolle bei der Gestaltung von YouTube als Plattform, die für Nutzer und Urheber auf der ganzen Welt tätig ist.

Mit einem „Mensch + Maschine“-Ansatz hat YouTube erhebliche Fortschritte bei der Durchsetzung der Community-Richtlinien gemacht. Um mehr zu erfahren, besuchen Sie bitte unseren Bericht zu den YouTube Community-Richtlinien und ihrer Durchsetzung3.

3 https://transparencyreport.google.com/youtube-policy/overview

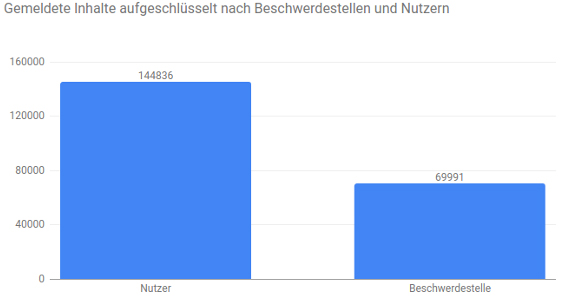

Anzahl der im Berichtszeitraum gemeldeten Inhalte

Die hier aufgeführten Angaben beinhalten nur Beschwerden, die sich explizit auf das NetzDG bezogen haben. Eine einzelne Beschwerde kann mehrere Inhalte (z.B. mehrere Videos oder Kommentare) enthalten, die wir jeweils einzeln als Inhalt ausweisen. Die nachfolgenden Grafiken geben Aufschluss über die Gesamtzahl der im sechsmonatigen Berichtszeitraum gemeldeten Inhalte.

Wir führen zwei Kategorien von Beschwerdeführern auf: diejenigen, die Angaben als Beschwerdestelle gemacht haben, und diejenigen, die Angaben als Nutzer gemacht haben. Diese Daten beruhen allein auf der Auswahl des Beschwerdeführers bei Einreichung der Beschwerde und wir können nicht überprüfen, ob ein Beschwerdeführer, der „Beschwerdestelle“ auswählt, tatsächlich mit einer Beschwerdestelle in Verbindung steht.

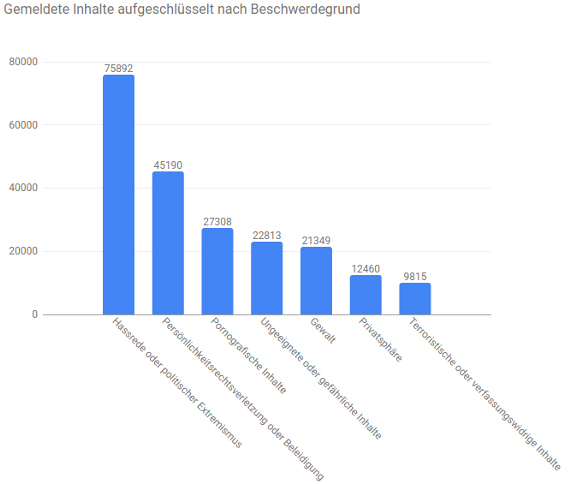

Die untenstehende Grafik zeigt die Anzahl der uns im Berichtszeitraum gemeldeten Inhalte aufgeschlüsselt nach Beschwerdegrund. Diese Grafik gibt nur den Grund wieder, der zum Zeitpunkt der Beschwerde durch den Beschwerdeführer angegeben wurde, nicht hingegen den tatsächlichen Grund für die Entfernung.

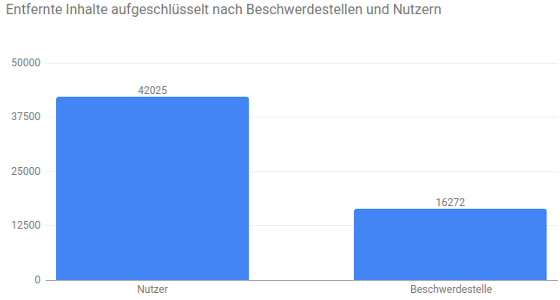

Anzahl der entfernten Inhalte

Die Grafiken in diesem Abschnitt zeigen die Anzahl der Inhalte, die im Berichtszeitraum zu einer Entfernung oder Sperrung geführt haben.

Wir führen zwei Kategorien von Beschwerdeführern auf: diejenigen, die Angaben als Beschwerdestelle gemacht haben, und diejenigen, die Angaben als Nutzer gemacht haben. Diese Daten beruhen allein auf der Auswahl des Beschwerdeführers bei Einreichung der Beschwerde und wir können nicht überprüfen, ob ein Beschwerdeführer, der „Beschwerdestelle“ auswählt, tatsächlich mit einer Beschwerdestelle in Verbindung steht.

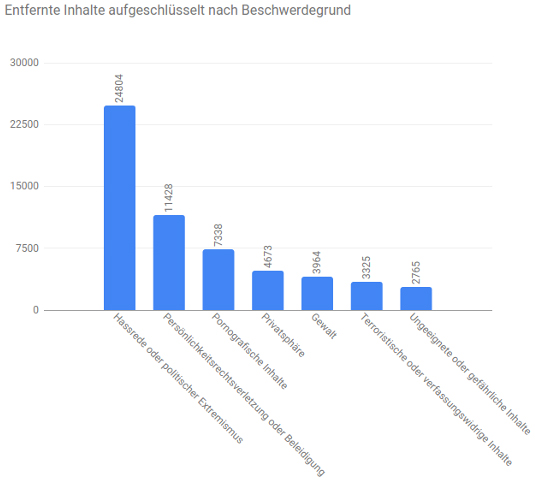

Die untenstehende Grafik zeigt die Anzahl der von uns im Berichtszeitraum entfernten Inhalte aufgeschlüsselt nach Beschwerdegrund. Der von einem Beschwerdeführer gemeldete Grund für eine Beschwerde und der letztendlich für die Entfernung ausschlaggebende Grund sind möglicherweise nicht identisch. Diese Grafik gibt lediglich den angegebenen Grund für die Beschwerde wieder.

Diese Tabelle zeigt die Anzahl der Beschwerden, die wir von uns bekannten Beschwerdestellen aus dem Bereich des NetzDG erhalten haben. Nur diese Beschwerdestellen haben einen Auftrag zur Bekämpfung von Inhalten über sexuellen Kindesmissbrauch, der sich aus Vereinbarungen mit dem Bundeskriminalamt (BKA) und der Bundesprüfstelle für jugendgefährdende Medien (BPjM) ergibt: Eco, Freiwillige Selbstkontrolle Multimedia-Diensteanbieter e.V. und Jugendschutz.net.

Beschwerdestelle Entfernungsrate (i)

| Beschwerdestelle | Gemeldete Inhalte | Entfernte Inhalte |

| FSM | 6 | 5 |

| Jugendschutz.net | 3 | 1 |

| Eco | 1 | 1 |

Einholen von Informationen bei Beschwerdeführern und Inhalteerstellern

Das NetzDG gestattet Sozialen Netzwerken, den Inhalteersteller zu kontaktieren, wenn die Entscheidung über die Rechtswidrigkeit eines Inhalts von der Unwahrheit einer Tatsachenbehauptung abhängt. Um eine substantiierte Antwort des Inhalteerstellers zu erhalten, bedarf es einer ebenso substantiierten und rechtlich begründeten Beschwerde durch den Beschwerdeführer, aus der hervorgeht, warum die gerügte Tatsachenbehauptung angeblich unwahr ist. Aufgrund des Umstandes, dass die Mehrheit der Rechtsbeschwerden, die im Rahmen des NetzDG an uns heran getragen werden, unsubstantiiert ist (auch nachdem YouTube weiterführende Informationen bei dem Beschwerdeführer erfragt hat), gibt es in diesen Fällen keinen hinreichenden Grund zur Kontaktaufnahme mit dem Inhalteersteller.

Gesamtzahl der Inhalte, die wir an den Inhalteersteller weitergeleitet haben, um seine Sicht auf die betreffende Beschwerde zu erhalten.

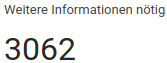

Gesamtzahl der Beschwerden, bei denen wir weitere Informationen vom Beschwerdeführer benötigten.

Anzahl der Beschwerden, bei denen eine externe Stelle konsultiert wurde

Es gibt Fälle im Strafrecht, die spezifisches juristisches Fachwissen erfordern. Dies sind Fälle, in denen wir eine externe Stelle konsultieren können, z.B. eine auf Strafrecht spezialisierte Anwaltskanzlei oder eine Einrichtung der Regulierten Selbstregulierung im Rahmen des NetzDG.

Gesamtanzahl der an eine Einrichtung der Regulierten Selbstregulierung weitergeleiteten Inhalte.

Gesamtanzahl der an eine auf Strafrecht spezialisierte Anwaltskanzlei weitergeleiteten Inhalte.

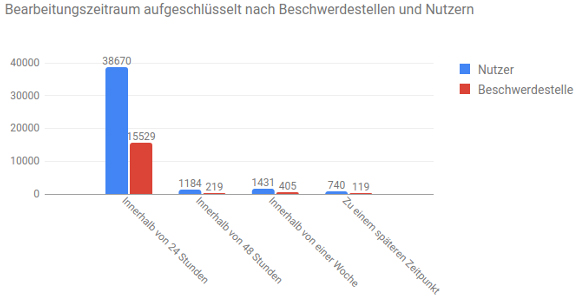

Vorgegebene Bearbeitungszeit

Die Grafiken in diesem Abschnitt zeigen die Gesamtanzahl der Inhalte, die wir im Berichtszeitraum entsprechend der vorgegebenen Bearbeitungszeit entfernt haben. Die vorgegebene Bearbeitungszeit ist die Zeitspanne, die zwischen dem Eingang einer Beschwerde und der Bearbeitung der gemeldeten Inhalte vergeht. Dies beinhaltet nicht die Zeit, in der wir auf weitere Informationen vom Beschwerdeführer warten mussten.

Die untenstehende Grafik zeigt die vorgegebene Bearbeitungszeit für entfernte Inhalte aufgeschlüsselt nach Beschwerdestellen und Nutzern. Diese Daten beruhen allein auf der Auswahl des Beschwerdeführers bei Einreichung der Beschwerde und wir können nicht überprüfen, ob ein Beschwerdeführer, der „Beschwerdestelle“ auswählt, tatsächlich mit einer Beschwerdestelle in Verbindung steht. Fälle können wegen technischer Probleme, komplexer Sachverhalte, bei denen wir externen Rat eingeholt haben, oder seltener Sprachen länger als sieben Tage dauern.

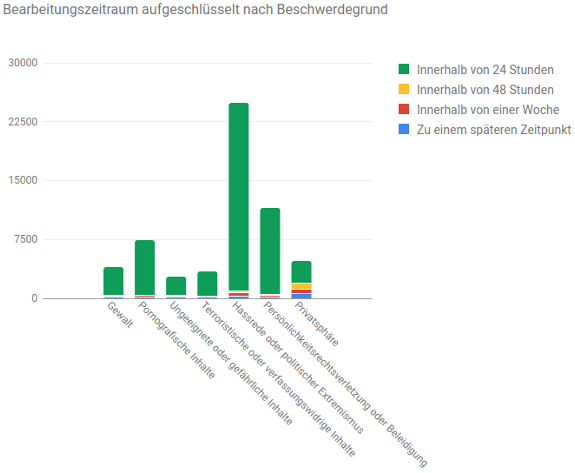

Diese Grafik zeigt die vorgegebene Bearbeitungszeit für entfernte Inhalte aufgeschlüsselt nach dem Grund der Beschwerde.

Bearbeitungszeitraum aufgeschlüsselt nach Beschwerdegrund

| Beschwerdegrund | Zu einem späteren Zeitpunkt | Innerhalb von 48 Stunden | Innerhalb von einer Woche | Innerhalb von 24 Stunden |

| Terroristische oder verfassungswidrige Inhalte | 30 | 52 | 112 | 3131 |

| Gewalt | 60 | 60 | 110 | 3734 |

| Persönlichkeitsrechtsverletzung oder Beleidigung | 94 | 112 | 176 | 11046 |

| Pornografische Inhalte | 54 | 62 | 180 | 7042 |

| Ungeeignete oder gefährliche Inhalte | 59 | 58 | 152 | 2496 |

| Hassrede oder politischer Extremismus | 116 | 285 | 447 | 23956 |

| Privatsphäre | 446 | 774 | 659 | 2794 |

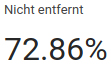

Prozentsatz der gemeldeten Inhalte, die wir nicht entfernt haben, weil diese nicht gegen unsere Community-Richtlinien oder gegen einen der im NetzDG genannten Straftatbestände verstoßen haben.

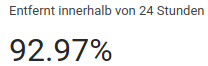

Prozentsatz der Inhalte, die innerhalb von 24 Stunden nach Erhalt einer Rechtsbeschwerde entfernt wurden. Größtenteils wurden die Inhalte aufgrund eines Verstoßes gegen die Community-Richtlinien von YouTube weltweit entfernt und nicht bloß lokal aufgrund eines rechtswidrigen Inhalts nach dem NetzDG gesperrt.

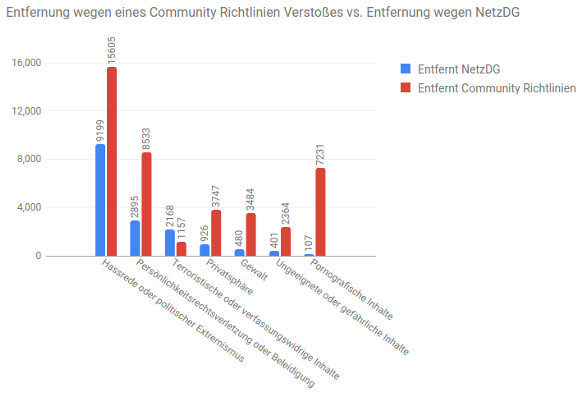

Entfernung von Inhalten wegen Verstößen gegen die Community-Richtlinien

Diese Grafik zeigt eine Gegenüberstellung der Inhalte, die aufgrund eines Verstoßes gegen unsere Community-Richtlinien weltweit entfernt wurden, mit den Inhalten, die lokal aufgrund der Verwirklichung einer der Straftatbestände, die vom NetzDG erfasst werden, gesperrt wurden. Ein Inhalt kann sowohl ein Verstoß unserer Community-Richtlinien als auch einen Rechtsverstoß im Rahmen des NetzDG darstellen. In solchen Fällen entfernen wir den Inhalt weltweit aufgrund unserer Community-Richtlinien. Wie die untenstehende Grafik zeigt, wird zum Beispiel die überwiegende Mehrheit der als Pornografie gemeldeten Inhalte gemäß unseren Community-Richtlinien und nicht gemäß nationaler, deutscher Gesetze entfernt.

Meldemechanismen, Transparenzmaßnahmen und Prüfverfahren

YouTube versucht, die „Vier YouTube Freiheiten“ – Meinungsfreiheit, Informationsfreiheit, Handlungsfreiheit und die Freiheit der Zugehörigkeit – in Balance zu halten und zu bewahren. Die Durchsetzung unserer Community-Richtlinien und/oder lokaler Gesetze ist Bestandteil dieser Balance zwischen den vier Freiheiten und dem Erhalt der YouTube Gemeinschaft. Diese Balance zu finden ist nicht einfach, insbesondere für eine weltweit agierende Plattform, die unterschiedlichen rechtlichen und kulturellen Standards unterworfen ist.

Mechanismen zur Übermittlung von Beschwerden über angeblich rechtswidrige Inhalte

Für Nutzer in Deutschland bietet YouTube ein leicht erkennbares, unmittelbar erreichbares und ständig verfügbares Meldeverfahren nach dem NetzDG. Dieses Meldeverfahren für bei YouTube angemeldete Nutzer ist in das sog. Flagging integriert, das unter jedem Video und neben jedem Kommentar zur Verfügung steht. Um eine Beschwerde nach dem NetzDG einzureichen, muss der Beschwerdeführer lediglich das Kästchen „Meines Erachtens sollte dieser Inhalt gemäß dem Netzwerkdurchsetzungsgesetz gesperrt werden. Weitere Informationen4.” anklicken; es öffnet sich dann ein kurzes Formularfeld, in das für eine rechtliche Prüfung erforderliche Informationen eingetragen werden können. Für nicht angemeldete Nutzer bietet YouTube eigens ein NetzDG-Meldeformular an, das über das YouTube-Impressum5 (eine Kontaktseite für alle Nutzer in Deutschland) zugänglich ist. Daneben haben wir allen YouTube-Nutzern bereits vor Inkrafttreten des NetzDG Meldeformulare für Rechtsverletzungen zur Verfügung gestellt (z.B. für Persönlichkeitsrechtsbeschwerden, Urheberrechtsbeschwerden, Markenbeschwerden usw.). Demnach haben wir Meldeverfahren für Rechtsverletzungen nicht erst aufgrund des NetzDG eingeführt. Das NetzDG hat lediglich dazu beigetragen, unsere bestehenden Meldeverfahren enger miteinander zu verknüpfen – und zwar das sog. Flagging für Verstöße gegen die Community-Richtlinien und die Meldeformulare für angeblich rechtswidrige Inhalte nach dem NetzDG.

4 https://support.google.com/youtube/?p=Netz_DG&hl=de

5 https://www.youtube.com/t/impressum?hl=de&gl=DE

Maßnahmen zur Unterrichtung des Beschwerdeführers und des Inhalteerstellers

Wenn wir eine Beschwerde im Hinblick auf das NetzDG über das soeben beschriebene Meldeverfahren bekommen, erhält der Beschwerdeführer eine Bestätigungs-E-Mail mit einer Referenznummer, aus der hervorgeht, dass wir seine Beschwerde erhalten haben und diese überprüfen werden. Nach der Überprüfung senden wir dem Beschwerdeführer eine E-Mail mit Informationen über die Entscheidung der Beschwerde. Dies können Informationen über eine Entfernung sein, wenn sich der gerügte Inhalt für uns als rechtswidrig darstellt oder er gegen unsere Community-Richtlinien verstößt, oder aber auch Informationen über nicht getroffene Maßnahmen mangels Rechtswidrigkeit oder eines Community-Richtlinienverstoßes. Bei Entfernung eines Inhalts senden wir ebenso eine Benachrichtigung an den Inhalteersteller mit entsprechenden Informationen über die Entfernung sowie mit Anweisungen, wie er einen Antrag für eine erneute Überprüfung seines Inhalts stellen kann. Auch beinhaltet die Nachricht an den Inhalteersteller zusätzliche Informationen über unsere Nutzungsbedingungen oder lokales Recht, so dass in Zukunft keine derartigen Inhalte mehr hochgeladen werden. Wenn ein Video auf der Grundlage der Community-Richtlinien entfernt oder aufgrund des lokalen Rechts gesperrt wurde, zeigen wir an Stelle des Inhalts einen öffentlich zugänglichen Hinweis, der die Nutzer darüber informiert, dass der Inhalt nicht mehr verfügbar ist.

Sonstige Meldemechanismen

Während YouTube gewachsen ist und sich die Technologie weiterentwickelt hat, haben sich auch die Systeme von YouTube weiterentwickelt, einschließlich automatischer Meldemechanismen zur Unterstützung unserer Prüfer. Die heutigen automatischen Meldemechanismen nutzen neue technologische Entwicklungen, um Inhalte zu erkennen, die gegen unsere Community-Richtlinien verstoßen könnten. Im Folgenden finden Sie einen Überblick über die von YouTube eingesetzten Mechanismen.

Automatisierter maschineller Abgleich. YouTube’s Systeme setzen bereits an dem Punkt an, an dem ein Inhalteersteller ein Video hochlädt. YouTube verwendet Technologien, um das erneute Hochladen von bereits bekannten unzulässigen Inhalten zu verhindern, unter anderem durch die Verwendung von Hashes. Hashes sind eindeutige digitale Fingerabdrücke für Bilder und Videos, die uns helfen, ein erneutes Hochladen von exakt übereinstimmenden Videos zu verhindern, die wegen Verstößen gegen die Community-Richtlinien entfernt wurden. Für einige Inhalte, wie Bilder von sexuellem Kindesmissbrauch und Videos zur Rekrutierung von Terroristen, verwendet YouTube auch eine von der Industrie gemeinsam gepflegte Datenbank von Hashes, um die Menge der Inhalte zu erhöhen, die unsere Technologien beim Hochladen blockieren können.

Automatische maschinelle Meldungen. Im Juni 2017 haben wir damit begonnen, maschinelles Lernen einzusetzen, um möglicherweise gewalttätige extremistische Inhalte zu kennzeichnen und diese einer manuellen, menschlichen Prüfung zuzuführen. YouTube nutzt den Bestand an Videos, die bereits auf gewalttätigen Extremismus hin manuell überprüft und entfernt wurden, um unsere Systeme des maschinellen Lernens zu trainieren, damit neue Inhalte automatisch gemeldet werden, die ebenfalls gegen die Community-Richtlinien verstoßen könnten. Der Einsatz von Systemen des maschinellen Lernens, die durch menschliche Entscheidungen geschult werden, führt dazu, dass die Systeme im Laufe der Zeit immer genauer werden. Nach ersten positiven Ergebnissen haben wir daher begonnen, unsere Systeme des maschinellen Lernens bezüglich anderer, schwierig zu beurteilender Inhalte zu trainieren, einschließlich Inhalte, die zu Hass und Hetze aufrufen und Kinder ausbeuten. An dieser Stelle ist jedoch zu betonen, dass solche automatischen Systeme nur dann effektiv eingesetzt werden können, wenn es eine klar definierte, kontextunabhängige Verletzungshandlung gibt. Eine menschliche Beurteilung in all ihren feinen Nuancen kann eine Maschine nicht leisten.

Meldungen der YouTube Gemeinschaft. Wir bieten unseren Nutzern ein Meldesystem (sog. Flagging), durch das sie uns auf Inhalte aufmerksam machen können, die möglicherweise gegen unsere Community-Richtlinien verstoßen. Dabei handelt es sich um ein freiwilliges Selbstregulierungssystem, das unabhängig von jeder rechtlichen Verpflichtung besteht. Daneben haben wir ein Programm namens Trusted Flagger entwickelt, dass das simultane Melden mehrerer Inhalte durch Experten ermöglicht. Sog. Trusted Flagger (vertrauensvolle Melder) sind NGOs, Behörden und auch Privatpersonen, die uns regelmäßig einschlägige Inhalte melden und durch ihre Expertise einen wertvollen Beitrag für die YouTube Gemeinschaft leisten. Detaillierte Informationen über das Trusted Flagger-Programm finden Sie in unserem Bericht zur Durchsetzung der YouTube-Community-Richtlinien6.

Rechtliche Meldungen. Wie bereits erläutert, haben wir zusätzliche Meldemöglichkeiten für Beschwerdeführer geschaffen, um uns Inhalte zu melden, die gemäß dem NetzDG gesperrt werden sollten: zum einen ein Meldeformular7, das über das YouTube-Impressum erreichbar ist und zum anderen das direkte Meldeverfahren im Rahmen des sog. Flagging (durch Anklicken des NetzDG Kästchens). Diese Meldemöglichkeiten ermöglichen den Nutzern, den beanstandeten Inhalt sowie den Beschwerdegrund konkret zu benennen. Nur anhand dieser Informationen ist es uns möglich, eine ordnungsgemäße rechtliche Prüfung durchzuführen, um dann ggf. entsprechende Maßnahmen einleiten zu können. Ist die Beschwerde unsubstantiiert oder gibt es keine hinreichende Rechtfertigung für eine lokale Sperrung, treten wir gegebenenfalls an den Beschwerdeführer heran und bitten um weitere Informationen.

Die Bereitstellung eines intuitiven und unmittelbar erreichbaren Meldeverfahrens direkt neben den Inhalten führt naturgemäß zu einer hohen Anzahl an Klicks und Meldungen. Solche Meldungen sind nicht immer zuverlässig. Viele der Meldungen stehen in keinem Zusammenhang zum deutschen Strafrecht oder sind völlig unsubstantiiert, so dass wir keine Maßnahmen ergreifen. Andere Beschwerdeführer melden Inhalte ohne weitere Informationen, warum diese angeblich rechtswidrig sind. Dies ist insbesondere dann problematisch, wenn die Inhalte nicht offensichtlich rechtswidrig sind.

6 https://transparencyreport.google.com/youtube-policy/overview?hl=de

7 https://support.google.com/youtube/contact/netzdg

Prüfverfahren

Die weltweiten Community-Richtlinien von YouTube sind klare, übergeordnete Regeln, die hier8 abrufbar sind. Diese Richtlinien haben sich mit dem Wachstum von YouTube und dem veränderten Nutzerverhalten weiterentwickelt. Unsere Nutzer erklären sich damit einverstanden, diese Richtlinien einzuhalten, bevor sie einen YouTube-Kanal eröffnen.

Inhalte, die uns – wie oben beschrieben – gemeldet wurden, prüfen wir anhand aller unserer Community-Richtlinien. Die für das NetzDG relevantesten Richtlinien sind die Folgenden: Nacktheit und sexuelle Inhalte 9, schädliche oder gefährliche Inhalte10, Hassreden11, gewalttätige oder anderweitig explizite Inhalte12, Belästigung und Cyber-Mobbing13, Drohungen14 und die Gefährdung von Kindern15.

Neben den öffentlich zugänglichen Community-Richtlinien arbeitet YouTube auch mit internen, umfangreichen Auslegungskriterien für die einheitliche Durchsetzung dieser Richtlinien. Diese Auslegungskriterien sind detailliert und werden kontinuierlich angepasst, so dass sie auf sich ändernde Trends und neue Formen kontroverser Inhalte im Internet Anwendung finden. Beispielsweise verbieten die Community-Richtlinien Inhalte, die den Terrorismus fördern. Wenn eine terroristische oder verfassungswidrige Vereinigung einen neuen Zweig gründet, können die internen Auslegungskriterien mit Informationen über diese spezielle Gruppe aktualisiert werden; so verfügen die Prüfer über das notwendige Wissen, um Inhalte zu entfernen, die für diese Gruppe werben. YouTube veröffentlicht diese Art von Aktualisierungen nicht immer, um Missbrauch durch Nutzer zu verhindern.

Die Prüfteams können den Kontext eines gemeldeten Inhalts während ihrer Prüfung sehen, einschließlich der Videobeschreibung, anderer in den Kanal hochgeladener Inhalte sowie der Metadaten (Titel, Tags oder Bildunterschriften). Diese kontextabhängigen Hinweise sind wichtig für die Beurteilung der Intention des Inhalteerstellers. Darüber hinaus erfasst unser System den Zeitstempel, zu welchem Zeitpunkt des Videos der Inhalt gemeldet wurde; auch bitten wir die Beschwerdeführer in unseren Meldeformularen, den einschlägigen Zeitstempel anzugeben. So können sich unsere Prüfer auf die potenziell kritischen Abschnitte innerhalb eines Videos konzentrieren.

Wir haben Ausnahmen von den Community-Richtlinien für pädagogisches, dokumentarisches, wissenschaftliches und/oder künstlerisches Material (EDSA) erarbeitet. Videos, die unter diese Ausnahmen fallen sind wichtig, um das Weltgeschehen und geschichtliche Entwicklungen besser zu verstehen, seien es Kriege und Revolutionen oder künstlerische Ausdrucksformen. Die Auslegungskriterien von YouTube helfen den Prüfern, die EDSA-Ausnahmen zu verstehen und bei ihrer Prüfung entsprechend anzuwenden. Doch selbst mit gut formulierten Kriterien kann die Entscheidung, welche Videos den EDSA-Ausnahmen unterliegen und welche nicht, eine komplexe Abwägung für die Prüfer bedeuten.

8 https://www.youtube.com/intl/de/yt/about/policies/#community-guidelines

9 https://support.google.com/youtube/answer/2802002?hl=de

10 https://support.google.com/youtube/answer/2801964?hl=de

11 https://support.google.com/youtube/answer/2801939?hl=de

12 https://support.google.com/youtube/answer/2802008?hl=de

13 https://support.google.com/youtube/answer/2802268?hl=de

14 https://support.google.com/youtube/answer/2801927?hl=de

15 https://support.google.com/youtube/answer/2801999?hl=de

Unterrichtung des Inhalteerstellers und Antrag auf erneute Überprüfung

Wenn YouTube ein Video entfernt, das gegen die Community-Richtlinien verstößt, informiert YouTube den Inhalteersteller über die Entfernung und die Gründe dafür. Wie das Beispiel unten zeigt, erläutern wir dem Inhalteersteller, warum sein Inhalt entfernt wurde, wir stellen einen Link zur Verfügung, über den er mehr über die Entfernung seines Inhalts erfahren kann, sowie einen Link zu einem Antragsformular auf erneute Überprüfung seines Inhalts, sollte er mit der Entscheidung von YouTube nicht einverstanden sein. Bereits seit vielen Jahren haben Inhalteersteller die Möglichkeit, ihre Inhalte erneut durch YouTube überprüfen zu lassen, wenn sie der Ansicht sind, dass ihr Inhalt nicht gegen unsere Community-Richtlinien verstößt. Das Verfahren zur erneuten Überprüfung wird hier16 ausführlich erklärt. Wenn wir feststellen, dass der Inhalt tatsächlich irrtümlich entfernt wurde, korrigieren wir dies, indem wir den betreffenden Inhalt wiederherstellen.

16 https://support.google.com/youtube/answer/185111?hl=de

Hallo

In unseren Community-Richtlinien wird beschrieben, welche Inhalte auf YouTube erlaubt sind und welche nicht. Dein Video “MOVIE.m4v” wurde zur Überprüfung gemeldet. Bei der Überprüfung haben wir festgestellt, dass dein Video gegen unsere Richtlinien verstößt. Deshalb haben wir dieses Video aus YouTube entfernt. Außerdem hat dein Konto eine Verwarnung wegen der Verletzung unserer Community-Richtlinien bzw. vorübergehende Strafe erhalten.

Beschränkungen für Videoinhalte

Wir treten für das Recht der freien Meinungsäußerung jedes einzelnen Nutzers ein. Dies gilt auch dann, wenn es sich um nicht besonders beliebte Meinungen handelt. Hassreden werden von YouTube allerdings unter keinen Umständen geduldet. Die Unterscheidung, ob es sich bei bestimmten Inhalten um Hassreden handelt oder nicht, ist allerdings nicht immer ganz einfach. Solltest du dir bei einem Video nicht sicher sein, welcher Kategorie es zuzuordnen ist, bitten wir dich, von einer Veröffentlichung abzusehen. Weitere Informationen findest du hier.

Auswirkung von Verwarnungen

Dies ist die erste Verwarnung für dein Konto. Wir wissen, dass die Nutzer auf YouTube nur selten absichtlich gegen unsere Richtlinien verstoßen. Deshalb gelten unsere Verwarnungen lediglich für einen bestimmten Zeitraum. Diese Verwarnung läuft in drei Monaten ab. Falls du noch mehr Verwarnungen erhälst, kann es aber sein, dass du keine Inhalte mehr auf YouTube posten darfst. Im schlimmsten fall kann sogar dein Konto gekündigt werden.

So kannst du reagieren

Wenn du der Meinung bist, dass ein Fehler vorliegt, kannst du dich gern bei uns melden. Bitte führe die folgenden zwei Maßnahmen durch. Wenn du lediglich das betroffene Video löschst, wird die Verwarnung dadurch nicht aufgehoben.

| • |

Bei deiner nächsten Anmeldung wirst du aufgefordert, diese Verwarnung für dein Konto zu bestätigen. |

| • |

Wenn du gegen diese Verwarnung Beschwerde einlegen möchtest, reiche dieses Formular ein. Unser Team wird deine Beschwerde bearbeiten und sich in Kürze bei dir melden. |

Viele Grüße

Das YouTube-Team

Grundsätzlich entfernen unsere Prüfteams Inhalte weltweit, wenn sie gegen unsere Community-Richtlinien verstoßen. Der Zugang zu Inhalten wird lokal gesperrt, die als rechtswidrig in einem Land eingestuft wurden. Hinzu kommen weitere Maßnahmen, die unsere Teams durchführen können.

| • |

Altersbeschränkung17. Einige Videos verstoßen nicht gegen unsere Community-Richtlinien und sind auch nicht rechtswidrig, sind aber möglicherweise nicht für alle Zielgruppen geeignet. In diesen Fällen und nach entsprechender Beschwerde können unsere Prüfteams eine Altersbeschränkung für die Videos festlegen. Altersbeschränkte Videos sind nicht sichtbar für Nutzer, die ausgeloggt oder unter 18 Jahre alt sind, oder den Eingeschränkten Modus18 aktiviert haben. Sobald wir ein Video mit einer Altersbeschränkung versehen haben, teilen wir dem Inhalteersteller per E-Mail mit, dass sein Video altersbeschränkt ist und er gegen diese Entscheidung einen Antrag auf erneute Überprüfung seines Inhalts einreichen kann. |

| • |

Eingeschränkte Funktionen19. Wenn unsere Prüfteams feststellen, dass ein Video im Rahmen unserer Community-Richtlinien grenzwertig ist, können einige Funktionen rund um das Video deaktiviert werden. Diese Videos bleiben zwar auf YouTube verfügbar, werden aber hinter einer Warnmeldung angezeigt; einige Funktionen werden deaktiviert, einschließlich der Möglichkeit das Video zu teilen, zu kommentieren, anderen vorzuschlagen oder weiterzuempfehlen. Sobald wir ein Video auf diese Weise eingeschränkt haben, teilen wir dem Inhalteersteller per E-Mail mit, dass sein Video eingeschränkt ist und er gegen diese Entscheidung einen Antrag auf erneute Überprüfung seines Inhalts einreichen kann. |

| • |

Als privat gesperrt20. Wenn ein Video gegen unsere Richtlinie über irreführende Metadaten verstößt, kann es als privat gesperrt werden. Es ist dann für die Öffentlichkeit nicht mehr sichtbar. Das ist auch dann der Fall, wenn der Nutzer auf einen konkreten Link zu diesem Video klickt. Sobald wir ein Video als privat gesperrt haben, teilen wir dem Inhalteersteller per E-Mail mit, dass sein Video nicht mehr öffentlich zugänglich ist und er gegen diese Entscheidung einen Antrag auf erneute Überprüfung seines Inhalts einreichen kann. |

17 https://support.google.com/youtube/answer/2802167

18 https://support.google.com/youtube/answer/174084?hl=de

19 https://support.google.com/youtube/answer/7458465?&ref_topic=2803138

20 https://support.google.com/youtube/answer/7300965?&ref_topic=2803138

Bei wiederholtem Missbrauch oder schwerwiegenden Verstößen können bestimmte Funktionen deaktiviert oder Nutzerkonten gekündigt werden. Grundsätzlich akzeptieren Nutzer mit den Community-Richtlinien, dass drei Verstöße zur Kündigung eines Nutzerkontos führen; bei eklatanten Verstößen, wie zum Beispiel Terrorismus, können wir Nutzerkonten aber auch direkt kündigen.

Rechtliche Beschwerden. Wenn wir eine rechtliche Beschwerde erhalten, führen unsere Prüfteams eine rechtliche Prüfung auf der Grundlage der in der Beschwerde enthaltenen Informationen durch, einschließlich der Prüfung des vom Beschwerdeführer angegebenen Beschwerdegrunds. Im Rahmen dessen betrachten wir selbstverständlich auch den Kontext, in dem der gerügte Inhalt steht (z.B. Metadaten, Titel, etc.). Wenn wichtige Informationen in einer Beschwerde fehlen – der Beschwerdeführer zum Beispiel anonym bleibt, gleichzeitig aber eine Verletzung seiner Persönlichkeitsrechte rügt – werden die Prüfteams den Beschwerdeführer in der Regel kontaktieren, um weitere Informationen zu erfragen, die für eine rechtliche Prüfung erforderlich sind. Kommen wir nach der Prüfung zu dem Ergebnis, dass der Inhalt nach deutschem Recht rechtswidrig ist, sperren wir ihn lokal.

Beschwerden nach NetzDG. Im Rahmen unseres Prüfverfahrens prüfen wir bei Eingang einer NetzDG-Beschwerde zunächst den beanstandeten Inhalt anhand unserer weltweit geltenden Community-Richtlinien. Verstößt der Inhalt nicht gegen diese Community-Richtlinien, prüfen unsere Prüfteams den Inhalt in einem zweiten Schritt anhand der Straftatbestände, auf die sich das NetzDG bezieht (§1 Abs. 3 NetzDG).

Es ist unwahrscheinlich, dass Beschwerdeführer, die juristische Laien sind, die einschlägigen Straftatbestände bei der Einreichung ihrer Beschwerde kennen und jeweils den richtigen angeben können. Um das Beschwerdeverfahren zu vereinfachen und die Beschwerdeführer bei der Einreichung ihrer Beschwerden nach NetzDG zu unterstützen, haben wir für das NetzDG Meldeverfahren sieben Inhaltskategorien gebildet, die die 22 einschlägigen Straftatbestände erfassen und allgemeinverständlich kategorisieren. Diese Kategorien sind:

| • |

Hassrede oder politischer Extremismus |

| • |

Terroristische oder verfassungswidrige Inhalte |

| • |

Gewalt |

| • |

Schädliche oder gefährliche Handlungen |

| • |

Persönlichkeitsrechtsverletzung oder Beleidigung |

| • |

Privatsphäre |

| • |

Pornografische Inhalte |

Einige Inhalte können dabei mehreren Kategorien unterfallen. Beispielsweise kann die Verbreitung von Propagandamitteln verfassungswidriger Organisationen (§ 86 StGB) oder die Verwendung von Kennzeichen verfassungswidriger Organisationen (§ 86a StGB) gleichzeitig auf Hassrede hinweisen und Anhaltspunkt für terroristische oder verfassungswidrige Inhalte sein. Ähnlich verhält es sich mit dem Tatbestand der Störung des öffentlichen Friedens durch Androhung von Straftaten (§ 126 StGB), der für terroristische oder verfassungswidrige Inhalte charakteristisch sein, aber auch als schädliche oder gefährliche Handlungen eingestuft werden kann.

Einige der Straftatbestände sind kaum greifbar, wie z.B. die Fälschung beweiserheblicher Daten (§ 269 StGB). Das Äußerungsrecht ist ein Bereich, in dem sich in den letzten Jahrzehnten, insbesondere seit Inkrafttreten des Grundgesetzes, eine umfassende Rechtsprechung etabliert hat. Das Ermitteln von Rechtsverletzungen erfordert in diesem Bereich oftmals nicht nur eine genaue Kenntnis des jeweiligen Kontextes, in den eine Äußerung eingebettet ist, sondern darüber hinaus regelmäßig eine komplexe Abwägung der involvierten Interessen. In diesen Fällen ist die Rechtmäßigkeit der Inhalte oft sehr schwer zu beurteilen und sollte – jedenfalls in Grenzfällen – in der Regel besser von den zuständigen Gerichten beurteilt werden.

Insbesondere im Bereich der Persönlichkeitsrechtsverletzungen lässt sich in den wenigsten Fällen von einer offensichtlichen Rechtswidrigkeit sprechen. Gerichte benötigen mitunter Jahre, um einen bestimmten Inhalt äußerungsrechtlich als zulässig oder unzulässig einzustufen, und kommen dabei oft zu unterschiedlichen Ergebnissen. Insbesondere das Bundesverfassungsgericht hat in dem Bereich des Äußerungsrechts immer wieder gezeigt, dass die rechtliche Bewertung komplexe Abwägungsvorgänge erfordert, einzelfallabhängig ist und stets der jeweilige Kontext einer Äußerung bei dessen Bewertung eine entscheidende Rolle spielt. Anders als bei gerichtlichen Verfahren, innerhalb derer umfassend Beweis erhoben werden kann, verfügen Soziale Netzwerke nicht immer über alle notwendigen Informationen, um eine rechtlich fundierte Entscheidung treffen zu können. Es gibt insbesondere kein Erkenntnisverfahren, das bestimmten Beweisregeln unterliegt.

Diese Erwägungen sind nicht bloß theoretischer Natur, sondern werden nahezu täglich durch die Praxis bestätigt: Viele äußerungsrechtliche Beschwerden, die im Rahmen des NetzDG bei uns eingehen, werden beispielsweise nicht von der betroffenen Person selbst, sondern von Dritten eingereicht, die lediglich davon ausgehen, dass sich die betroffene Person in ihren Persönlichkeitsrechten verletzt fühlen könnte. Ob dies tatsächlich der Fall ist, ist dem Sozialen Netzwerk nicht bekannt. Ebensowenig übrigens, ob die betroffene Person etwa eine Strafanzeige bei den zuständigen Strafverfolgungsbehörden gestellt hat – die Verfolgung dieser Straftaten erfordert einen Antrag durch den Betroffenen (sog. Antragsdelikte).

Prüfteams

Obwohl sich Technologien weiterentwickelt haben, die bei der Identifizierung einiger Arten von kontroversen Inhalten helfen – z.B. die Objekte und Muster schnell und maßstabsgetreu in Bildern, Videos und Audioaufnahmen finden – sind es nach wie vor Menschen, die den Kontext beurteilen können. Beispielsweise können Algorithmen nicht den Unterschied zwischen terroristischer Propaganda und kritischer Berichterstattung über solche Organisationen oder zwischen volksverhetzenden Inhalten und politischer Satire erkennen. Deshalb müssen in der Regel Menschen – gerade in Bereichen, in denen die Meinungsfreiheit betroffen ist – die Inhalte letztlich beurteilen.

Die Prüfung von Inhalten, die uns durch das sog. Flagging sowie durch rechtliche Beschwerden übermittelt werden, wird gestützt durch unsere Technologien und durchgeführt von YouTube- und Google-Mitarbeitern oder externen Dienstleistern, bei Bedarf auch mit Unterstützung durch externe Anwaltskanzleien. Wir führen regelmäßige Qualitätsprüfungen durch, um sicherzustellen, dass unsere Mitarbeiter weltweit die richtigen Entscheidungen über beanstandete Inhalte treffen und regelmäßig Feedback zu ihren Entscheidungen erhalten. Unsere Prüfteams bestehen aus Tausenden von Mitarbeitern, die eine Vielzahl von Sprachen fließend beherrschen und die gemeldete Inhalte 24 Stunden am Tag, sieben Tage die Woche und 365 Tage im Jahr in Zeitzonen auf der ganzen Welt überprüfen. Diese Teams haben deutschsprachige Mitarbeiter, einige von ihnen sind deutschsprachige Juristen. Die Mitarbeiter sind auf lokale Gesetze geschult und können sich mit Mitarbeitern aus den lokalen Google Rechtsabteilungen beraten. Google beschäftigt ein großes Team von Juristen in vielen europäischen Ländern. Sie werden bei Bedarf in die rechtliche Analyse der Inhalte einbezogen; die Teams können zusätzliche Rechtsberatung durch externe Anwaltskanzleien vor Ort in Anspruch nehmen.

Je nach Anzahl der eingehenden Beschwerden nach NetzDG kann die Anzahl der Prüfer variieren, die die YouTube Support Teams und die Google Rechtsabteilung unterstützen. Derzeit arbeiten rund 100 Prüfer eines externen Dienstleisters ausschließlich an Beschwerden, die über die NetzDG Meldeverfahren bei YouTube und Google+ eingereicht werden. Um die kulturelle Vielfalt zu gewährleisten, haben diese Prüfer unterschiedliche berufliche Hintergründe, sprechen verschiedene Sprachen und kommen aus unterschiedlichen Altersgruppen. Wir bieten regelmäßig, mindestens halbjährlich, Schulungen zur Anwendung unserer Community-Richtlinien sowie rechtliche Schulungen an, die von YouTube- und Google-Mitarbeitern, Mitgliedern der deutschen Rechtsabteilung von Google sowie externen Rechtsexperten wie Strafrechtsanwälten und Rechtsprofessoren durchgeführt werden. Umfangreiche Betreuungsangebote und psychologische Unterstützung stehen allen Prüfern zur Verfügung, z.B. regelmäßige Beratungen durch Psychologen. Wir stellen auch Einrichtungen zur Verfügung, die das Wohlbefinden unterstützen, wie z.B. Ruheräume und spezielle Privaträume für individuelle Therapiegespräche. Dies ist konsistent mit unseren Betreuungsangeboten, die wir allen Mitarbeitern bei Google und YouTube zur Verfügung stellen, die in diesen Bereichen arbeiten.

Mitgliedschaft in Industrieverbänden

YouTube ist über Google in den folgenden, für das NetzDG einschlägigen Branchenverbänden vertreten:

| • |

Freiwillige Selbstkontrolle Multimedia-Diensteanbieter e.V. (FSM)21 |

| • |

eco – Verband der Internetwirtschaft e.V.22 |

| • |

Deutschland sicher im Netz e.V.23 |

| • |

Bitkom-Bundesverband Informationswirtschaft, Telekommunikation und neue Medien e.V.24 |

Die FSM und der Verband eco betreiben Hotlines, über die Verbraucher Kontakt aufnehmen und Beschwerden über angeblich rechtswidrige Inhalte einreichen können. Im Falle einer vermuteten Rechtswidrigkeit leitet die Hotline den Inhalt an den Provider zur Überprüfung weiter. In jedem Fall senden wir eine detaillierte Rückantwort mit Informationen zu der von uns getroffenen Entscheidung an die Beschwerdestelle.

Zusammenarbeit ist der entscheidende Faktor in der Bekämpfung rechtswidriger Inhalte. Wir arbeiten daher auch eng mit Bürgerrechtsgruppen zusammen, deren Ziel es ist, gegen Hassrede und Diskriminierungen vorzugehen, sowie mit Behörden, um lokale Vorgaben umzusetzen und gemeinsame Lösungen zu erarbeiten. Regelmäßig überprüfen wir unsere Community-Richtlinien und die zugehörigen Auslegungskriterien gemeinsam mit externen Partnern und Experten. Ebenso laden wir NGOs ein, an lokalen oder auch länderübergreifenden Workshops teilzunehmen, in denen wir sie über unsere Community-Richtlinien und Produktänderungen informieren, sie in der Nutzung der Google-Dienste, aber auch in Sicherheitsmaßnahmen bezüglich der Dienste schulen und mit ihnen über aktuelle Herausforderungen und Kernfragen diskutieren.

21 http://www.fsm.de/de

22 https://www.eco.de/

23 https://www.sicher-im-netz.de/

24 https://www.bitkom.org/

Beispiele für Meldungen

In jedem Berichtszeitraum sammeln wir eine Reihe von Beispielen, die unsere Entscheidungen über angeblich rechtswidrige Inhalte besser veranschaulichen, um damit ein Bild über die Breite der von dem NetzDG abgedeckten Inhalte und die Art der von uns zu entfernenden Inhalte zu zeichnen.

Rechtlich nicht relevante Beschwerde, Beispiel 1

Ein Musikvideo, das einen nackten Mann zeigt, der auf künstlerische Weise aus dem Meer entsteigt, wurde mehrmals wegen angeblich rechtswidrigen sexuellen Inhalts gemeldet.

Rechtlich nicht relevante Beschwerde, Beispiel 2

Eine Rede von Angela Merkel über die Zugehörigkeit des Islams zu Deutschland wurde sowohl als Hassrede als auch als terroristischer Inhalt gemeldet, weil Angela Merkel nach Ansicht der Beschwerdeführer den Staat in Gefahr bringe und Deutschland in eine Katastrophe führe.

Rechtlich nicht relevante Beschwerde, Beispiel 3

Ein Video von Jan Böhmermann, in dem er eine rechtsextreme Gruppe zum Gegenstand einer kritischen und satirischen Diskussion macht, erhielt mehrere Meldungen wegen angeblicher Hassrede, Gewalt, Spam, Verleumdung und Beleidigung.

Rechtlich nicht relevante Beschwerde, Beispiel 4

Ein Kommentar, welcher das Kuscheln zu Hause anpreist, wurde als schädliche oder gefährliche Handlung gemeldet.

Fälle, die von einer externen Strafrechtskanzlei geprüft wurden, Beispiel 1

Ein Video, das einen bekannten deutschen islamischen kontroversen Prediger zeigt, der zu Dua und Tawaf aufruft, wobei abgehackte Takbir-Rufe aus dem Publikum zu hören sind. Das Video wurde unter dem NetzDG für terroristische Inhalte gemeldet. Von der externen Strafrechtskanzlei wurde es als rechtmäßig beurteilt. Es enthielt keine Propaganda.

Fälle, die von einer externen Strafrechtskanzlei geprüft wurden, Beispiel 2

Ein Video, dass Aufnahmen von Waffen und völlig verschwommen Aufnahmen von Leichen aus einem Kriegsgebiet zeigt; das Akronym YPG wird in der rechten Ecke angezeigt. Die externe Strafrechtskanzlei hat weder rechtswidrige Zeichen noch einen Aufruf zur Propaganda feststellen können.

Fälle, die von einer externen Strafrechtskanzlei geprüft wurden, Beispiel 3

Ein Video, in welchem die ersten Sekunden des Horst Wessels-Liedes, die nunmehr verbotene Hymne der NSDAP, gespielt werden, gefolgt von Reden von AfD-Politikern im Deutschen Bundestag. Die externe Strafrechtskanzlei beurteilte dies als eine Verwendung rechtswidriger Kennzeichen.

Kontextbeispiel 1

Ein Video einer historischen antisemitischen Rede, das von einem Rabbiner hochgeladen wurde, um die Existenz solcher Ansichten bloßzustellen und zu kritisieren, wäre unter unseren weltweiten Community-Richtlinien wahrscheinlich zulässig. Wir können diesen Zusammenhang womöglich anhand der Videobeschreibung und anderer Inhalte erkennen, die auf dem Kanal des Videokünstlers hochgeladen wurden. Würde der selbe Inhalt jedoch hochgeladen, um solche Ansichten zu verherrlichen oder zu ermutigen, würde er wahrscheinlich unsere Community-Richtlinien verletzen und deshalb entfernt werden.

Kontextbeispiel 2

Ein Video eines Terroranschlags kann eine informative Nachrichtenberichterstattung sein, wenn es von einer Nachrichtenagentur oder einem Zeitzeuge hochgeladen wird. Das gleiche Video kann jedoch für die Rekrutierung verwendet werden, wenn er von der Terrororganisation selbst in dem Bestreben hochgeladen wird, zu verherrlichen oder zu rekrutieren. Informative Nachrichten wären im Rahmen unserer weltweiten Community-Richtlinien wahrscheinlich erlaubt, während die Rekrutierung von Terroristen gegen unsere Community-Richtlinien verstoßen und deshalb entfernt werden würden.

Bildungsbeispiel: Videos von Nutzern, die sich einer Mastektomie unterzogen haben, die Patienten aufklären und informieren, sind auf YouTube üblich. Diese Videos enthalten oft Informationen darüber, wie das Verfahren funktioniert und welche Techniken es zur Selbstversorgung nach der Operation gibt. Einige Videos können entblößte Brüste oder grafische Operationsbilder zeigen, sie sind jedoch wegen ihren pädagogischen Zwecks erlaubt.

Dokumentarisches Beispiel: Es gibt Videos auf YouTube, die das ehemalige deutsche NS-Regime und das Leben Hitlers dokumentieren. Dieses Filmmaterial enthält z.B. Zeichen, die in Deutschland normalerweise rechtswidrig sind. Diese Videos sind jedoch aufgrund ihres dokumentarischen Charakters nicht gesetzlich verboten.

Wissenschaftliches Beispiel: Obwohl wir Inhalte nicht zulassen, die schockieren oder Ekel erregen sollen, machen wir Ausnahmen für wissenschaftliche Inhalte, die in erster Linie der Aufklärung der Zuschauer dienen. So kann es z.B. für Nutzer schwierig sein, ein Video einer Tiersektion zu sehen. Wenn das Video aber eine Kommentierung eines Tierarztes oder Experten enthält, bleibt es auf der Plattform.

Künstlerisches Beispiel: Ein deutsches Kunst- und Aktivistenkollektiv schafft subversive Performancekunst mit dem Ziel, das Engagement der Zivilgesellschaft für mutigere Kampagnen herauszufordern. Mehrmals infiltrierte das Kollektiv mit falschen Identitäten Ereignisse als Akt des zivilen Ungehorsams. Einige ihrer Videos rufen zu rechtswidrigen Handlungen auf und verbergen ihre wahre Identität. Diese Art von Inhalten würde typischerweise gegen die weltweiten Community-Richtlinien von YouTube verstoßen, in diesem künstlerischen Kontext darf der Inhalt jedoch bestehen bleiben.

Verleumdung/ Beleidigung, Beispiel 1

Ein Unternehmen erhob eine Verleumdungsklage gegen ein Video von jungen Erwachsenen, die den Veranstaltungsraum des Unternehmens kritisieren und mit anderen Wettbewerbern vergleichen. Preis, Ausstattung und Größe des Veranstaltungsortes sind Gegenstand der Diskussion. Das Unternehmen behauptet, diese Aussagen seien unwahr.

Verleumdung/ Beleidigung, Beispiel 2

Ein Geschäftsführer eines Unternehmens erhob eine Verleumdungsklage gegen mehrere Videos, in denen ihm und dem Unternehmen betrügerische Aktivitäten vorgeworfen wurden. Der Hauptvorwurf ist, dass das Unternehmen seine positiven Online-Rezensionen fälschen würde. Der Geschäftsführer behauptet, diese Aussagen seien unwahr.

Verleumdung/ Beleidigung, Beispiel 3

Wir erhielten mehrere Beschwerden wegen angeblicher Beleidigungen Dritter, insbesondere in Spiel- und Musikvideos. Aussagen wie frech, arrogant oder aufdringlich wurden als rechtswidrige Beleidigungen gemeldet.